فایل robots.txt یک فایل متنی است که برای کنترل دسترسی رباتها (مانند رباتهای موتور جستجو) به صفحات مختلف سایت استفاده میشود. این فایل به موتورهای جستجو میگوید که کدام قسمتهای سایت باید ایندکس شوند و کدام قسمتها باید نادیده گرفته شوند. این فایل در دایرکتوری اصلی وبسایت قرار میگیرد و دارای دستورات خاصی است که به رباتها اطلاعات میدهد.

robots.txt فقط یک دستورالعمل است و رباتها میتوانند از آن پیروی نکنند، این فایل نمیتواند از محافظت امنیتی سایت جلوگیری کند، بلکه صرفاً برای مدیریت ایندکسینگ و دسترسی موتورهای جستجو طراحی شده است، همچنین این فایل میتواند به سئو (SEO) سایت کمک کند و از ایندکس شدن بخشهایی از سایت که نمیخواهید در نتایج جستجو نمایش داده شوند، جلوگیری کند.

مراحل طراحی فایل robots.txt چیست؟

برای طراحی و ایجاد یک فایل robots.txt مراحل مشخصی وجود دارد که به شما کمک میکند تا به درستی دسترسی رباتها به سایت خود را مدیریت کنید. این مراحل عبارتند از:

درک نیازهای خود

قبل از ایجاد robots.txt، باید بدانید که هدف شما چیست. این فایل برای مدیریت دسترسی موتورهای جستجو و سایر رباتها به سایت شما استفاده میشود. سوالاتی که باید بپرسید شامل:

آیا میخواهید برخی بخشها از ایندکسینگ موتور جستجو خارج شوند؟

آیا نیاز دارید تا دسترسی خاصی به رباتها بدهید؟

آیا برخی رباتها باید از صفحات خاصی دور بمانند؟

ایجاد فایل robots.txt

robots.txt یک فایل متنی ساده است که میتوانید با استفاده از ویرایشگر متن (مثل Notepad در ویندوز یا TextEdit در مک) ایجاد کنید. نام فایل باید دقیقاً robots.txt باشد.

مکان مناسب قرار دادن فایل

robots.txt باید در پوشه اصلی (ریشه) سایت شما قرار گیرد، توجه داشته باشید که این فایل باید در دایرکتوری ریشه (Root Directory) وبسایت شما باشد تا توسط رباتها به درستی شناسایی شود.

آزمایش و بررسی فایل

پس از ایجاد و قرار دادن فایل در سایت، بهتر است آن را آزمایش کنید تا مطمئن شوید که رباتها به درستی به دستورات آن عمل میکنند. برای این کار میتوانید از ابزارهای آنلاین مختلف مانند:

Google Search Console

robots.txt Tester

این ابزارها به شما کمک میکنند تا بررسی کنید که آیا فایل robots.txt به درستی کار میکند و آیا رباتها به درستی به صفحات دسترسی دارند یا خیر.

نگهداری و بهروزرسانی

فایل robots.txt ممکن است با گذشت زمان نیاز به تغییرات داشته باشد. مثلاً ممکن است بخواهید دسترسی رباتها به بخشهای جدید سایت را محدود کنید یا بخشهایی را که قبلاً محدود کرده بودید، باز کنید. بنابراین، بهتر است بهطور منظم فایل خود را بررسی کرده و تغییرات لازم را اعمال کنید.

ملاحظات امنیتی

robots.txt صرفاً برای موتورهای جستجو و رباتهای مطابق با استانداردهای robots.txt معتبر است. این فایل برای جلوگیری از دسترسی به اطلاعات حساس یا مخفی بهطور کامل امن نیست. اگر نیاز به حفاظت امنیتی دارید، بهتر است از روشهای دیگری مانند استفاده از رمزنگاری یا دسترسی محدود به بخشهای حساس استفاده کنید، اگر از دستور Disallow استفاده کنید، این به این معنی نیست که اطلاعات کاملاً از دسترس خارج میشوند. موتورهای جستجو ممکن است هنوز اطلاعات را کش کنند.

نکات اضافی

رباتها به ترتیب دستورات در فایل robots.txt عمل میکنند. پس در صورتی که دستور Allow و Disallow برای یک مسیر خاص تعریف شود، معمولاً Allow بر Disallow اولویت دارد.

فایل robots.txt چه ویژگی هایی دارد؟

فایل robots.txt دارای چند ویژگی مهم است:

موقعیت فایل

این فایل باید در ریشه (root) وبسایت قرار داشته باشد.

مسیر کامل آن باید به صورت “http(s)://example.com/robots.txt” باشد.

فرمت فایل

robots.txt به صورت متنی است و با پسوند “.txt” ذخیره میشود.

هر خط در فایل شامل یک دستور یا قاعده است.

فرمت دستورات شامل کلیدواژهها و مقادیر مربوطه است.

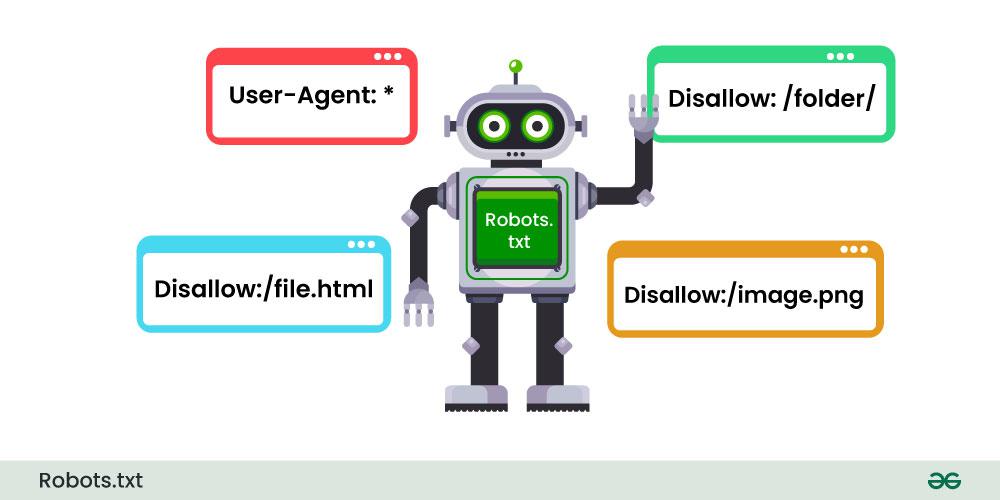

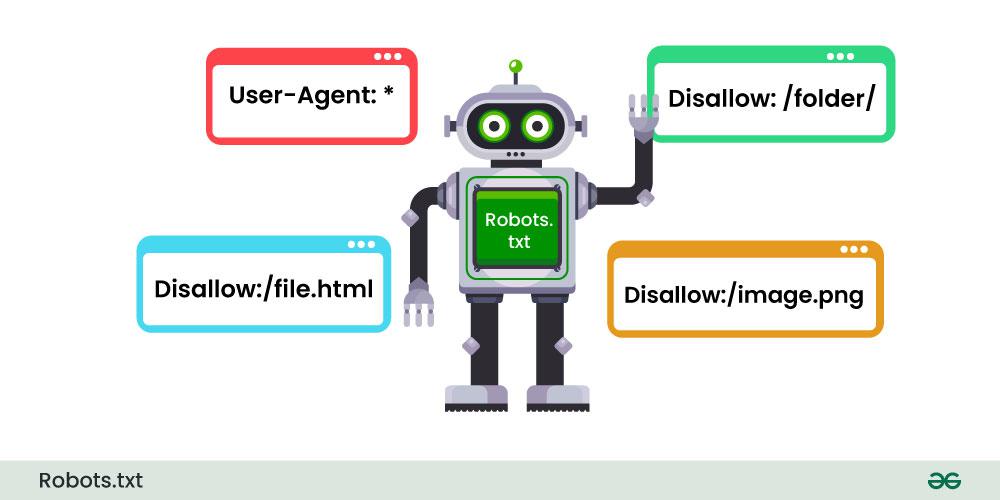

کلیدواژههای معمول

User-agent مشخص میکند که قاعده مربوط به کدام ربات است.

Disallow مشخص میکند که رباتها نباید به کدام صفحه یا پوشه دسترسی پیدا کنند.

Allow مشخص میکند که رباتها مجاز به دسترسی به کدام صفحه یا پوشه هستند.

Sitemap مشخص میکند که نقشه سایت در کدام آدرس قرار دارد.

اولویت بندی و ترکیب قوانین

قوانین براساس User-agent اعمال میشوند.

قوانین Disallow بر قوانین Allow اولویت دارند.

قوانین با محدودههای مسیر بیشتر بر قوانین با محدودههای کمتر اولویت دارند.

این ویژگیها به موتورهای جستجو کمک میکند که به درستی فایل robots.txt را تفسیر و اجرا کنند.

فایل robots.txt در چه اموری کاربرد دارد؟

robots.txt دارای کاربردهای متنوعی در مدیریت و بهینهسازی وبسایت است:

کنترل دسترسی موتورهای جستجو

میتوان با استفاده از Disallow برخی صفحات یا پوشههای حساس را از ایندکس شدن توسط موتورهای جستجو محافظت کرد.

این امر برای صفحات داخلی، صفحات مربوط به مدیریت سایت یا بخشهای خصوصی کاربران کاربرد دارد.

مدیریت بارگذاری سرور

با استفاده از دستور Crawl-delay میتوان سرعت کراول (بررسی صفحات) را توسط موتورهای جستجو کنترل کرد.

این ویژگی برای جلوگیری از بار بیش از حد سرور در زمان کراول مفید است.

معرفی نقشه سایت

با استفاده از دستور Sitemap، آدرس نقشه سایت (Sitemap) به موتورهای جستجو اعلام میشود.

این امر به بهبود ایندکسسازی صفحات توسط موتورهای جستجو کمک میکند.

اعلام محدودیتها

میتوان با استفاده از این فایل، محدودیتها و سیاستهای وبسایت را به موتورهای جستجو اعلام کرد.

این امر برای مدیریت کراول و ایندکسسازی صفحات مفید است.

در مجموع، robots.txt ابزار مفیدی برای کنترل و مدیریت حضور وبسایت در موتورهای جستجو محسوب میشود.

چگونه از افزونههای وردپرس برای بهینهسازی فایل robots.txt استفاده کنیم؟

برای بهینهسازی فایل robots.txt در وردپرس با استفاده از افزونهها، میتوانید به این روشها عمل کنید:

استفاده از افزونه Yoast SEO

افزونه Yoast SEO یکی از محبوبترین افزونههای SEO در وردپرس است.

در بخش “SEO” و سپس “robots.txt” در تنظیمات Yoast، میتوانید تنظیمات مربوط به فایل robots.txt را پیکربندی کنید.

این افزونه به صورت خودکار قوانین مناسب را تولید میکند و به روز نگه میدارد.

استفاده از افزونه All in One SEO Pack

افزونه All in One SEO Pack نیز یک ابزار قدرتمند برای بهینهسازی SEO در وردپرس است.

در بخش “General Settings” و زیربخش “robots.txt Editor”، میتوانید تنظیمات مربوط به فایل robots.txt را انجام دهید.

این افزونه به شما امکان ویرایش مستقیم محتوای فایل robots.txt را میدهد.

استفاده از افزونههای ویرایش robots.txt

برخی افزونههای تخصصیتر مانند “WP Robots.txt Editor” و “Robots.txt Editor” امکان ویرایش دقیقتر فایل robots.txt را فراهم میکنند.

این افزونهها به شما امکان اضافه کردن قوانین سفارشی، مدیریت دسترسی رباتها و نمایش تغییرات را میدهند.

در هر صورت، استفاده از این افزونهها میتواند بهینهسازی فایل robots.txt را سادهتر و کارآمدتر کند. همچنین بهطور خودکار قوانین مناسب را ایجاد و به روز نگه میدارند.

مزایا و معایب استفاده ازفایل robots.txt چیست؟

استفاده از فایل robots.txt در وردپرس دارای مزایا و معایب مختلفی است:

مزایای استفاده از فایل robots.txt

کنترل بهتر بر روی رباتهای جستوجوگر

با robots.txt میتوانید مشخص کنید کدام صفحات یا دایرکتوریهای سایت باید توسط رباتهای جستوجوگر بازدید شوند یا نشوند. این کار به بهبود رتبهبندی جستوجوی موتورهای جستوجو کمک میکند.

بهبود عملکرد سایت

با ممانعت از بازدید رباتهای غیرضروری از برخی صفحات یا دایرکتوریها، باعث بهبود عملکرد و سرعت بارگذاری سایت میشوید.

حفاظت از محتوای محرمانه

میتوانید از دسترسی رباتها به محتوای محرمانه سایت جلوگیری کنید.

معایب استفاده از فایل robots.txt

عدم پشتیبانی از همه موتورهای جستوجو

برخی موتورهای جستوجوی کوچکتر ممکن است از فایل robots.txt پشتیبانی نکنند.

عدم امنیت کامل

فایل robots.txt فقط یک راهنما برای رباتهای جستوجوگر است و به تنهایی نمیتواند مانع دسترسی به محتوای محرمانه شود.

شناخت ضعیف از فرمت فایل

اگر robots.txt به درستی پیکربندی نشود، ممکن است باعث بروز مشکلات در بازدید رباتهای جستوجوگر شود.

بنابراین، استفاده از robots.txt باید با دقت و درک کامل از آن صورت گیرد تا بتوان از مزایای آن استفاده کرد و از معایب آن اجتناب کرد.

شما می توانید برای استفاده از این قابلیت به سایت گرافتو مراجعه کنید و از نحوه استفاده و قابلیت های آن اطلاعات کسب کنید.

مقالات پیشنهادی شما :

فریم ورک (Framework) چیست، چه مزایا و کاربردی دارد ؟